信息论xinxilun

应用数学和其他科学方法研究系统中的信息传递和处理,信息识别和利用的共同规律的科学。

人类自诞生以来,一时一刻都没有离开过信息。信息论诞生前,人类用语言、文字、烽火以及各种电讯设备不自觉地利用着信息。随着社会生产的发展,信息的重要性日益显著。20世纪20年代以后,如何提高传递信息的能力和可靠性成为普遍重视的研究课题。40年代末,英国的费希尔,美国的申农和维纳三位数学家从不同角度研究信息,建立了信息论。其中,申农于1948年出版的《关于通讯的数学理论》一书,被认为是信息论诞生的标志。申农第一次从理论上阐明了通讯的基本问题,提出了通讯系统的数学模型,并找到了度量信息量的公式。70年代以来,随着数学计算机的广泛运用和社会信息化的发展,信息论正在逐渐突破申农等人建立的经典信息论,向更广阔的领域发展。

信息论的诞生,结束了人类不自觉地认识和利用信息的状态,对于推动现代科学的发展,促进社会信息化,具有重大意义。信息论所揭示的规律具有高度的普遍性。现在,它已被广泛运用于生物学、生理学、心理学、语言学和经济学等不同的领域,取得了丰硕的成果。

信息论xinxilun

以通信为背景,研究信息度量、传递和处理的一般规律的科学理论。1948年美国数学家C.E.仙农(Shannon)发表了著名长篇论文“通信的数学理论”,奠定了信息论的科学理论基础,以后逐渐发展成现代通信的基础理论。最近人们将信息的定义推广,信息论也逐渐被用来讨论在一般过程中人们如何获取信息、处理信息以及利用这些信息来解决系统演化和进行决策的有效理论。

信息论的主要内容在于给出了在通信意义下的信息定义,找到了信息传递系统的性能:信源具有的最大可能信息量,在一定失真度下必须传递的最小信息量,信道可能通过的最大信息容量等,以及这些量与系统的关系。信息论还建立了一组重要的编码定理,指出了应当遵循的信息处理(编码)的原则和方法。上述信息论属于狭义信息论的内容,它不考虑信息的语义内容,仅考虑它们的语法(形式)内容,因此只能用在通信工程上,不能用在如决策理论、思维科学、经济科学等学科中。现代信息论给出研究客观世界的信息方法,它包括信息分析方法和信息综合方法,前者指在分析复杂系统运动时,要从分析系统信息入手,研究系统内信息运动过程,建立信息模型,达到分析系统的目的;后者指在设计复杂系统时首先按照需要给出合理的信息模型,保证信息的演化、存贮、输出满足要求,然后再利用技术手段来实现信息模型,从而达到设计复杂系统的目的。

现代研究表明:物理学仅研究物质、能量的运动,已无法解决复杂系统的演化问题,信息论也不仅仅是通信过程需要研究的内容,物理学需要研究信息、信息论中也必须引入物理的方法。随着物理学和信息论的结合,必将促进物理学的发展,也将使信息论提高到一个新的水平。

信息论

见“哲学”中的“信息论”。

信息论

利用数学方法,研究信息的存储、计量、提取、加工、传递和变换规律的一门科学。于20世纪40年代建立起来的新兴学科。奠基人是美国科学家申农(C. Elwood Shanon,1916—)。他应用概率统计和数理统计,从量的方面来研究信息问题。其主要任务是把通讯的全部设备和过程当作一个系统来考察,提高传输信息的效能,保证传输信息的完整。它还包括噪声理论、信号滤波与预测、调制与信息处理等问题。目前已从通讯领域渗入各个科学技术领域,获得广泛运用。

信息论

见“逻辑学”中的“信息论”。

信息论

研究信息及其发展规律的一门学科。企业计划的依据和实施管理的手段。通过数据、凭证、图纸、报表、指令等形式反映客观世界中各种事物的特征和变化的程度。参见“哲学”部分“信息论”。

信息论

利用数学方法,研究信息的传送、变换和储存,特别是信息量计算的一门学科。所谓信息是指对消息接受者来说预先不知道的报道。它的任务在于解决通信上的两个基本问题:提高传送消息的效率和保证传送消息的完整。因此它对通信技术有重大意义。在计算技术、自动控制和遗传学等方面也有应用。

信息论information theory

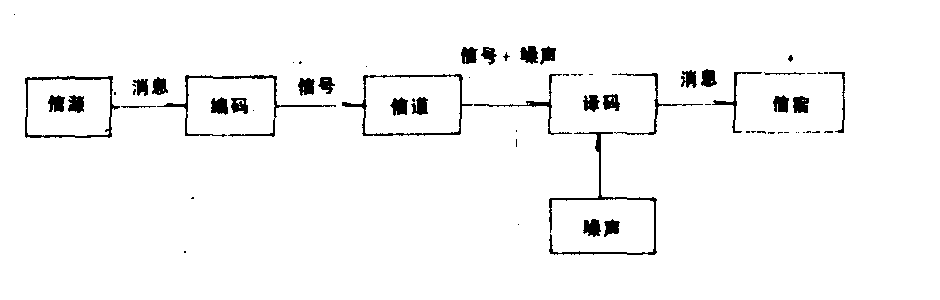

关于信息及其传输的基本规律的理论。狭义指研究通信和控制系统中信息处理和信息传递的普遍规律以及如何提高信息传递系统的有效性和可靠性的一 门通信理论;广义指利用狭义信息论观点来研究一切问题的理论。创始人是美国数学家香农(Claude Elwood Shannon,1916~)。他在1948年发表的《通信的数学理论》一文,奠定了信息论的基础。他认为通信的基本问题就是精确地或近似地在一点复现另一点选择的信号。一般的通信过程包括五个基本部分:信息源、发送机(编码器)、信道、接收机(解码器)和信息接收者(信宿)。他从理论上阐明了信源、信宿、信道和编码等有关通信方面的一些基本问题,创立了通信系统模型;建立了度量信息量的公式;初步解决了如何从信息接受端提取由信息源发来信息的技术问题;提出了充分利用信道的信息容量,在有限的信道中以最大的速率传递最大的信息量的基本途径;并着手解决充分表达信息源的信息,较好地利用信道容量的有关编、译问题。对信息论作出独特贡献的还有维纳(Norbert Wiener,1894~1964)。他在《平稳时间序列的外推、内摘和平滑化》、《控制论》等论著中对信息概念作了解释;建立了著名的维纳滤波理论和信号预测理论;阐明了信息定量化的原则和方法;并独立地提出了度量信息量的公式,为信息论的应用开辟了广阔的前景。当前,信息论已推广和渗透到科学技术的各个领域,不但推动了这些学科的发展,而且也促进了系统的信息科学的形成和发展。

信息论

研究信息过程一般规律的学科。20世纪40年代末,英国的费希尔、美国的申农和维纳分别从不同的角度研究信息,建立了信息论。申农1948年出版的《关于通讯的数学理论》一书被认为是这门学科诞生的标志。信息论的主要研究内容包括: 信息的变换和传递,信息的度量,信息的特征,信息方法等。当前信息论不仅是通信技术的基础理论,而且广泛应用于许多不同的领域。信息论是近年来我国介绍和研究得较多的一门新学科。

信息论

信息论是探讨信息的本质,并用数学方法研究信息的计量、传递、变换和存储,研究信息传递和信息处理系统中一般规律的新兴学科。核心问题是信息传输的有效性和可靠性以及两者间的关系。可有三种理解:狭义信息论,主要研究消息的信息量、信道容量以及消息的编码问题,一般信息论,主要研究通讯问题,包括噪声理论、信号滤波与预测、调制与信息处理等问题,广义信息论,包括狭义信息论和一般信息论,以及所有与信息有关的领域。

信息论萌芽于20世纪20年代,1924年—1928年,美国的奈奎斯特和哈特莱最早研究通信系统传输信息的能力,首先提出通信中的信息量概念,并试图度量系统的信息容量。1948年,美国数学家,麻省理工学院电气工程师C.E.香农发表了一篇讨论信源和信道特性的权威性论文《通信的数学理论》,奠定了现代信息论的基础,使信息论形成一门独立的学科。香农用负熵作为信息的度量,成功地解决了信息传输的基本问题。50年代,人们一方面在理论上阐明和推广香农的研究成果,把信息论置于严谨的数学基础上,另一方面发展了纠错码的理论和应用。60年代,在此基础上进一步发展,建立了信源编码的失真率理论,研究了最优信号集,发明了卷积码的序列译码和维特比译码技术。70年代,卫星通信和计算机技术的迅速发展给信息论以新的动力。各种多用户通信模型的信息传输理论获得了迅速发展。信息论已经发展成为 一门拥有众多分支的新兴学科。

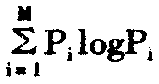

信息论研究的基本问题之一是信息的度量。对于应用范围如此广泛的信息提出一个统一的度量是困难的。美国数学家C.E.香农在1948年提出信息熵作为信息量的测度。根据人们的实践经验,一个事件给予人们的信息量多少,与这一事件发生的概率(可能性)大小有关。一个小概率事件的发生,如“唐山发生七级以上大地震”使人们感到很意外和震惊,它给人们的信息量就很多。相反一个大概率事件的出现,如“12月15日北京未下雪”给人们的信息量就很少。因此,用

I(A)=-logP(A)IP

来度量一次试验或一个消息所给出的平均信息量。当对数取2为底时,单位为比特,当对数取e为底时,则单位为奈特,H的表达式与熵的表达式差一个负号,故称负熵或信息熵。

来度量一次试验或一个消息所给出的平均信息量。当对数取2为底时,单位为比特,当对数取e为底时,则单位为奈特,H的表达式与熵的表达式差一个负号,故称负熵或信息熵。信息论的意义和应用范围已超出通信的领域。自然界和社会中有许多现象和问题,如生物神经的感知系统、遗传信息的传递等,均与信息论中研究的信息传输和信息处理系统相类似。因此信息论的思想对许多学科如物理学、生物学、遗传学、控制论,计算机科学、数理统计学、语言学、心理学、教育学、经济管理、保密学研究等都有一定的影响和作用。另一方面,由于借助负熵定义的信息量只能反映符号出现的概率分布(不肯定性),不能反映信息的语义和语用层次。一篇重要的报告和一篇胡说乱道的文章可以具有同样的信息,这显然不符合常识。因此现阶段信息论的应用又有很大的局限性。把信息的质量推广到适合于语义信息和语用信息的情况,至今没有显著进展。

信息论

信息论是探讨信息的本质,并用数学方法研究信息的计量、传递、变换和存储,研究信息传递和信息处理系统中一般规律的新兴学科。核心问题是信息传输的有效性和可靠性以及两者间的关系。可有三种理解:狭义信息论,主要研究消息的信息量、信道容量以及消息的编码问题,一般信息论,主要研究通讯问题,包括噪声理论、信号滤波与预测、调制与信息处理等问题,广义信息论,包括狭义信息论和一般信息论,以及所有与信息有关的领域。

信息论萌芽于20世纪20年代,1924年—1928年,美国的奈奎斯特和哈特莱最早研究通信系统传输信息的能力,首先提出通信中的信息量概念,并试图度量系统的信息容量。1948年,美国数学家,麻省理工学院电气工程师C.E.香农发表了一篇讨论信源和信道特性的权威性论文《通信的数学理论》,奠定了现代信息论的基础,使信息论形成一门独立的学科。香农用负熵作为信息的度量,成功地解决了信息传输的基本问题。50年代,人们一方面在理论上阐明和推广香农的研究成果,把信息论置于严谨的数学基础上,另一方面发展了纠错码的理论和应用。60年代,在此基础上进一步发展,建立了信源编码的失真率理论,研究了最优信号集,发明了卷积码的序列译码和维特比译码技术。70年代,卫星通信和计算机技术的迅速发展给信息论以新的动力。各种多用户通信模型的信息传输理论获得了迅速发展。信息论已经发展成为一门拥有众多分支的新兴学科。

信息论研究的基本问题之一是信息的度量。对于应用范围如此广泛的信息提出一个统一的度量是困难的。美国数学家C.E.香农在1948年提出信息熵作为信息量的测度。根据人们的实践经验,一个事件给予人们的信息量多少,与这一事件发生的概率(可能性)大小有关。一个小概率事件的发生,如“唐山发生七级以上大地震”使人们感到很意外和震惊,它给人们的信息量就很多。相反一个大概率事件的出现,如“12月15日北京未下雪”给人们的信息量就很少。因此,用

I (A) =-logP (A) IP

(A)表示事件A发生的概率来度量事件A给出的信息量,称为事件A的自信息量。若一次试验有M个可能结果(事件),或一个信源可能产生M个消息(事件),它们出现的概率分别用P1,P2……PM,则用H=-

PilogPi来度量一次试验或一个消息所给出的平均信息量。当对数取2为底时,单位为比特,当对数取e为底时,则单位为奈特,H的表达式与熵的表达式差一个负号,故称负熵或信息熵。

PilogPi来度量一次试验或一个消息所给出的平均信息量。当对数取2为底时,单位为比特,当对数取e为底时,则单位为奈特,H的表达式与熵的表达式差一个负号,故称负熵或信息熵。信息论的意义和应用范围已超出通信的领域。自然界和社会中有许多现象和问题,如生物神经的感知系统、遗传信息的传递等,均与信息论中研究的信息传输和信息处理系统相类似。因此信息论的思想对许多学科如物理学、生物学、遗传学、控制论,计算机科学、数理统计学、语言学、心理学、教育学、经济管理、保密学研究等都有一定的影响和作用。另一方面,由于借助负熵定义的信息量只能反映符号出现的概率分布(不肯定性),不能反映信息的语义和语用层次。一篇重要的报告和一篇胡说乱道的文章可以具有同样的信息,这显然不符合常识。因此现阶段信息论的应用又有很大的局限性。把信息的质量推广到适合于语义信息和语用信息的情况,至今没有显著进展。

信息论

美国教学家申农于1948年创立的一门新科学。初期的信息论主要是应用数理统计方法,研究通讯和控制系统中,普遍存在的信息传递的共同规律,以及如何提高各种信息传输系统的有效性和可靠性问题。因而,也称为狭义信息论。

申农对狭义信息论的主要贡献是,给出了度量信息量的数学公式;初步解决了从信息接收端提取由信息源发来的信息的技术性问题;提出了如何充分利用信道的容量,以最大速率传递最大信息量的基本途径;初步解决了如何编、译代码使信源的信息被充分表达、信道容量被充分利用的问题;从理论上阐明了通讯的基本问题并提出了通讯系统的模型,如下图:

信源:信息的发送者,可以是机器、人以及自然界的物体等等。

编码:把信息变换成为可以传输的电、光、声等信号。

信道:传递信号的通路如电线、电缆、光纤维、空气……等等。

噪声:信号传送过程中,由外界混入或由系统内部产生的一些不能完全消除的干扰信号。

译码:把信号译成由语言所表达的有思想内容的信息。

信宿:信息的接收者,可以是人、机器系统,或其他物体。

50年代以后一些学者(如法国物理学家L·布里渊等)把信息论推广到物理学等其它领域。到了60年代人们已经把信息论划分成三个不同的类型,即初期的狭义信息论;一般信息论,将噪声理论,信号滤波与预测,调制等列入了研究范围;广义信息论,即包括前两种内容,也包括与信息有关的生理学、心理学、语义学等方面内容。